GPT-4: un salto adelante en la Inteligencia Artificial

Descubre algunas de las características del modelo de lenguaje más avanzado hasta la fecha

A no ser que hayas estado un poco ausente esta semana pasada, ya sabrás que OpenAI ha lanzado su nuevo modelo de lenguaje: GPT-4. Apenas nos estábamos acostumbrando a trabajar con GPT-3 (o 3.5) cuando ya tenemos aquí su actualización, que promete ser bastante más avanzada.

GPT-4 es la cuarta evolución de la tecnología GPT (Generative Pre-trained Transformer), que se basa en una red neuronal profunda capaz de generar texto a partir de un input dado, ya sea una palabra, una frase o un párrafo. GPT-4, al igual que su versión anterior utiliza un algoritmo de aprendizaje automático llamado Transformer, que le permite captar el contexto y la semántica del texto, así como generar respuestas coherentes y fluidas. En este artículo desgranaremos algunos de sus avances más significativos, que según la propia OpenAI GPT-4 supera a su predecesor en:

Razonamiento avanzado

Seguir instrucciones complejas

Mayor creatividad

De hecho, en su paper, Open AI define a GPT-4 de la siguiente manera:

“GPT-4 es un modelo a gran escala multimodal que puede aceptar inputs de imagen y texto y producir outputs de texto. Aunque es menos capaz que los humanos en muchos escenarios del mundo real, GPT-4 muestra un rendimiento similar al de los humanos en varias pruebas de referencia profesionales y académicas, incluida la superación de un examen de abogacía simulado con una puntuación cercana a la del 10% de los mejores examinados. GPT-4 es un modelo Transformer preentrenado para predecir el siguiente token de un documento. El proceso de ajuste posterior al entrenamiento, ha dado lugar a una mejora del rendimiento en las medidas factuales y la adherencia al comportamiento deseado.”

Vamos a ver qué significa todo esto y cómo podemos sacarle el máximo partido.

Mayor capacidad

En comparación con GPT-3.5, GPT-4 es más fiable, creativo y capaz de manejar instrucciones mucho más complejas. Mientras trabaja con nosotros en actividades de escritura creativa y técnica, como componer canciones, escribir guiones o averiguar el estilo de escritura de un usuario, puede producir, editar e iterar junto a nosotros en el proceso de escritura. Es decir, hace “lo mismo” que GPT-3, pero mejor.

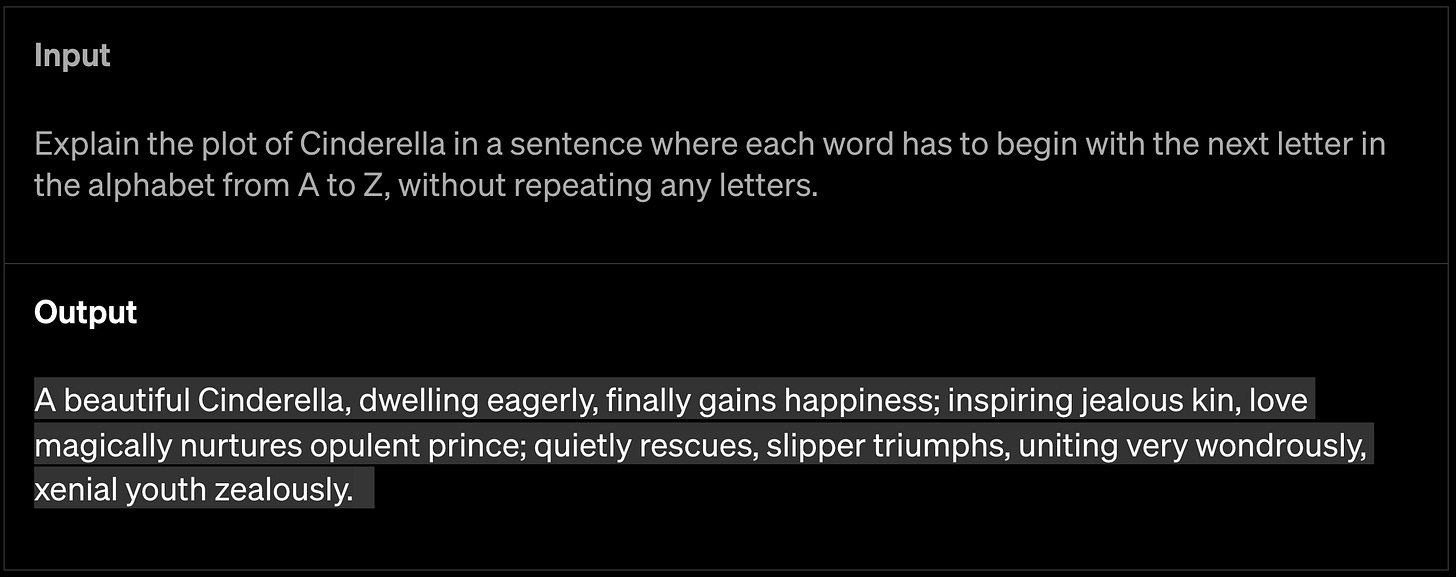

Prompt (input): “Explica el argumento de Cenicienta en una frase en la que cada palabra tenga que empezar por la siguiente letra del abecedario de la A a la Z, sin repetir ninguna letra.”

Esta mayor capacidad de procesamiento en parte es debida a que se ha ampliado el contexto que puede manejar el modelo. Esto implica que la cantidad de texto con la que puede trabajar GPT-4 es mucho mayor que en su versión anterior:

GPT-4 puede procesar más de 25.000 palabras de texto, lo que le permite tener un vocabulario más amplio y variado. Además, puede generar textos en más idiomas y con más estilos, desde el formal al coloquial, pasando por el humorístico o el poético. Lo que lo hace idóneo para tareas como la generación de contenidos de formato largo, conversaciones o diálogos extensos, así como la realización de búsquedas y análisis de documentos.

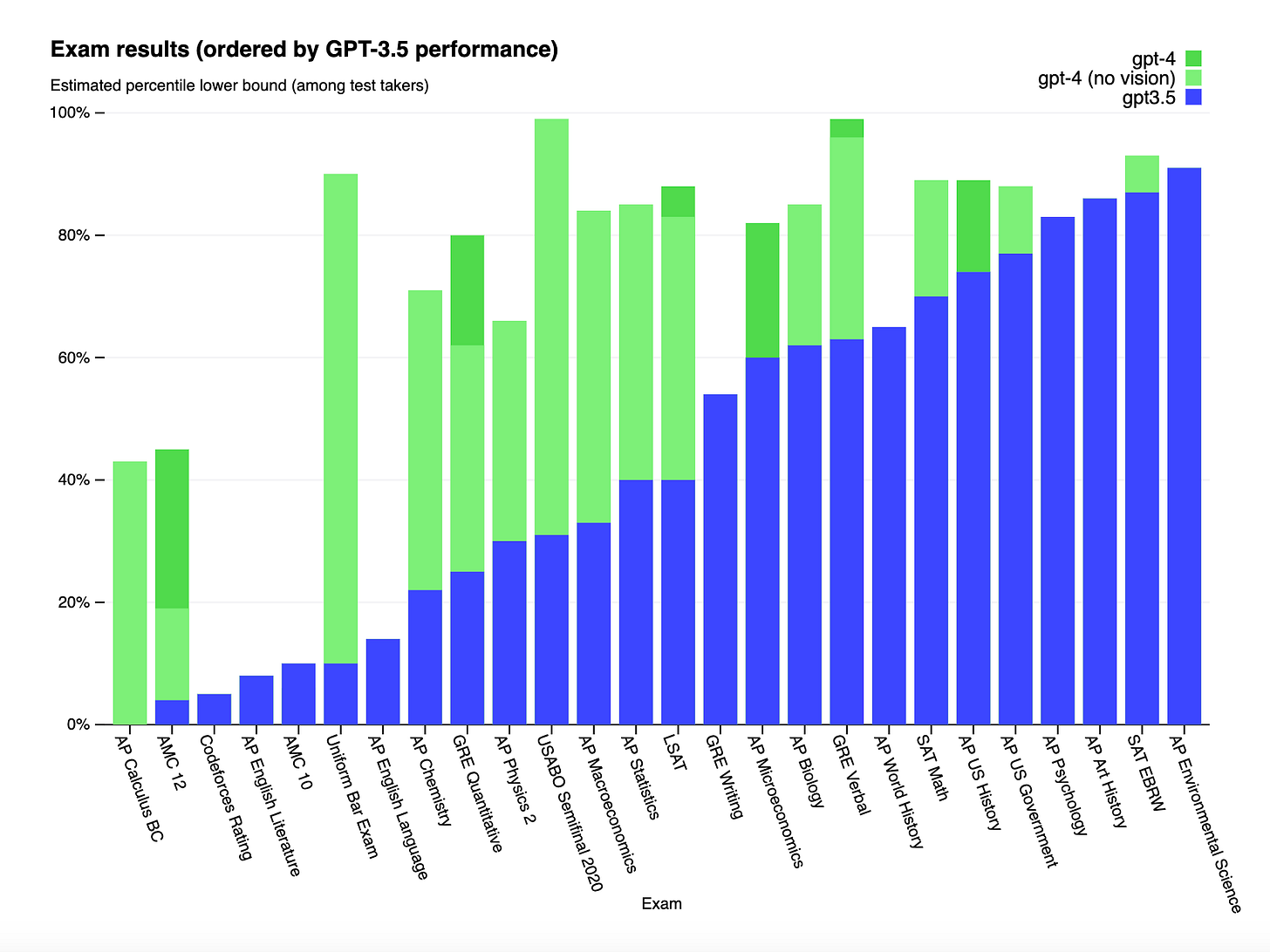

Tanto es así, que OpenAI sometió el nuevo modelo a pruebas diseñadas específicamente para humanos con el fin de evaluar sus capacidades, pero sin realizar ningún ajuste previo para que superase con éxito dichas pruebas. GPT-4 pasó con éxito las pruebas y obtuvo resultados muy superiores a los obtenidos por GPT-3.5.

También resaltan la mejora en cuanto a la capacidad de procesar información en otros idiomas diferentes del inglés, llegando a manejar un total de 26 idiomas. Además, con GPT-4, de esos 26, 24 obtienen mejores resultados que GPT-3.5 en inglés (que es el lenguaje “nativo” del modelo).

Mayor control

Todo lo expuesto anteriormente ha hecho que entre las mejoras de GPT-4 se encuentren una mayor diversidad y coherencia de los textos generados y una mejor comprensión del contexto y la intención del usuario. Estas mejoras permiten a GPT-4 producir textos más naturales, relevantes y creativos en diferentes registros y tareas. Además, al “tener” conocimientos más amplios y mayor capacidad de resolución de problemas es capaz de resolver cuestiones complejas con mayor precisión.

En una recopilación de datos que incluía 5.214 solicitudes enviadas a ChatGPT y a la API de OpenAI (Playground), en el 70% de los casos las respuestas de GPT-4 se prefirieron a las de GPT-3.5. Por otro lado, los usuarios de GPT-4 ahora pueden añadir más contexto y detallar mejor sus prompts desde el apartado “System” en la API. Ahora podemos especificar el estilo y las instrucciones escribiéndolas en esa sección para conseguir que ChatGPT actúe como nosotros queramos, por ejemplo desempeñando un rol o manteniendo un estilo concreto.

Multimodal

GPT-4 es un modelo multimodal que ahora también es capaz de “entender” texto e imágenes. Esta “multi-modalidad” le hace capaz de crear respuestas en forma de texto cuando le proporcionas un prompt que puede incluir tanto palabras como imágenes, en cualquier orden, o ambas. Estas imágenes pueden incluir capturas de pantalla, imágenes de documentos con texto, gráficos, diagramas o fotografías.

El primer ejemplo que muestran en su web, es el de una foto con una serie de ingredientes y se le pregunta a GPT-4 qué se puede cocinar con ellos. A lo que GPT-4, sin más contexto que la imagen proporcionada en el prompt, escribe una lista de platos que contienen esos ingredientes:

Teniendo esto en cuenta, GPT-4 sería capaz de explicar qué es gracioso en un meme (con lo complejo que puede resultar el humor), podría analizar los datos de un gráfico de barras, contestar a las preguntas de la fotocopia de un examen, extraer información de páginas de documentos con texto y analizarla, o encontrar y analizar cosas o conceptos inusuales en determinadas imágenes. Todos estos ejemplos podemos verlos en el apartado de research, donde profundizan un poco más.

Sin duda, el ejemplo que mayor impacto causó fue la demostración de Greg Brockman en la que convirtió un boceto hecho a mano de una página web en papel en una página web real y funcional a partir de una fotografía:

Una aplicación real de esta capacidad de interpretar imágenes la está llevando a cabo la empresa Be My Eyes en su aplicación de asistente visual para ayudar a personas con problemas de visibilidad.

Sin embargo, esta función de reconocimiento visual del modelo GPT-4 aún no ha sido puesta en manos del público general, y ellos mismos afirman que aún se encuentran investigando las posibilidades de esta nueva funcionalidad.

Limitaciones y riesgos

A pesar de sus avances, GPT-4 sigue teniendo limitaciones similares a las de los modelos anteriores. La más importante es que aún está lejos de ser 100% fiable: "alucina" y se inventa hechos y comete errores de razonamiento. Además, en general, GPT-4 no aprende de su experiencia y no es consciente de los acontecimientos que han tenido lugar después de la última fecha de actualización de sus datos (septiembre de 2021).

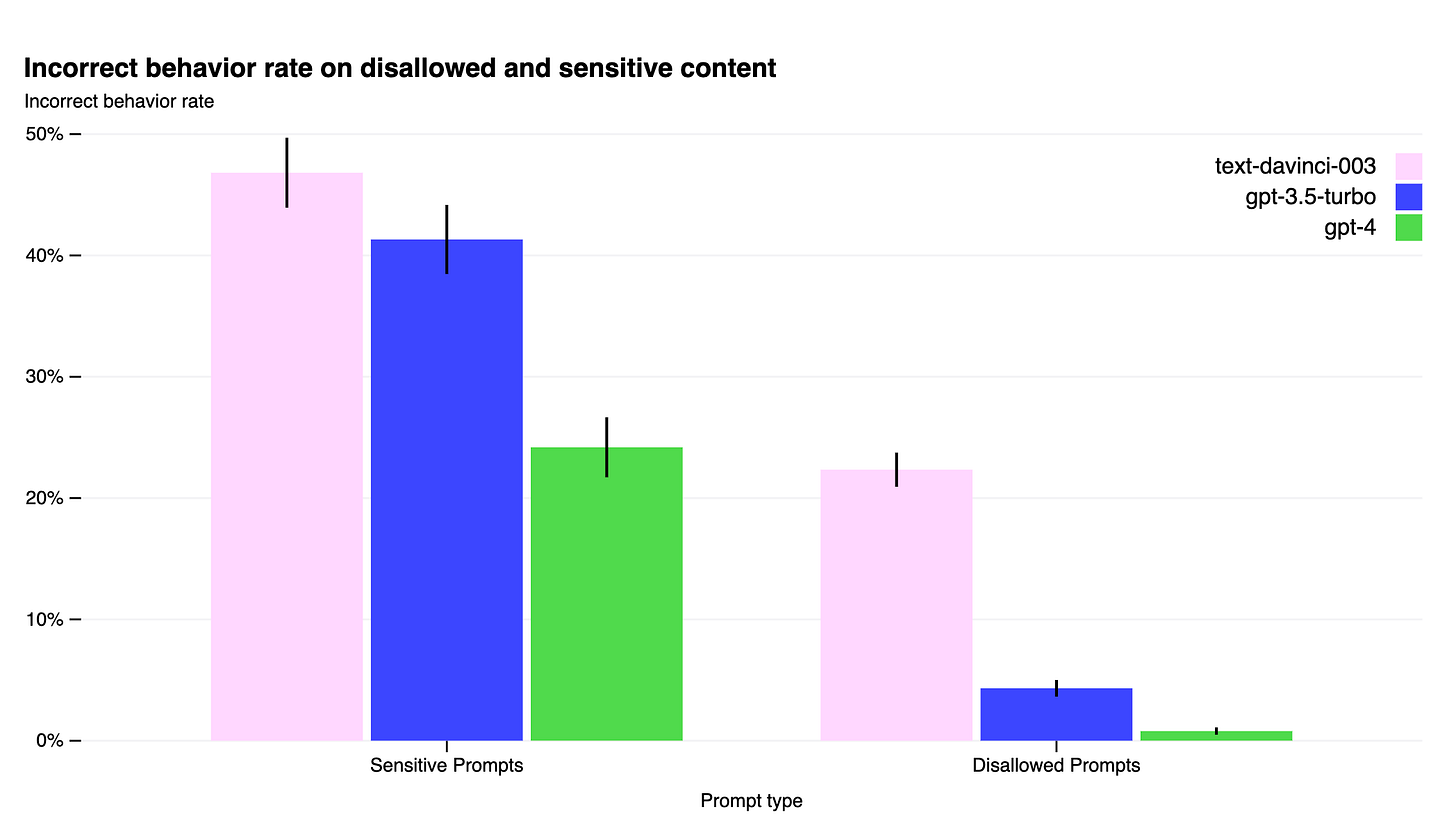

Sin embargo, según lo publicado por OpenAI, GPT-4 sí que reduce significativamente las alucinaciones en relación con las versiones previas. Así mismo, tiene un 82% menos de probabilidades de responder a solicitudes de contenido no permitido y suele responder con un 29% más de frecuencia a las solicitudes de información delicada (asesoramiento médico o peticiones de autolesión) siguiendo las políticas de uso de la compañía.

Casos de uso

Con el lanzamiento del nuevo modelo, OpenAI también anunció algunos partners que ya están utilizando GPT-4 o planean integrarlo de alguna manera. Aparte de grandes empresas como Microsoft, Morgan Stanley, Stripe o incluso el gobierno de Islandia, también están apostando por su integración en el sector educativo.

Ya anunciaron su colaboración con Quizlet, una plataforma online de estudio, y ahora han anunciado su colaboración con Duolingo y Khan Academy, dos de las plataformas de aprendizaje online más famosas a nivel mundial. Hablaremos de ellas en próximos artículos.

Para poder acceder a GPT-4, podemos hacerlo a través de la suscripción premium de ChatGPT, pidiendo acceso a la whitelist de la API, o de forma totalmente gratuita con el buscador de Bing de Microsoft.

GPT-4 es, sin duda, uno de los avances más importantes e impresionantes en el campo de la inteligencia artificial y el procesamiento del lenguaje natural. Sin embargo, también plantea algunos desafíos éticos y sociales como el control de la veracidad y la calidad de los textos generados por el modelo. Por eso es importante que tanto los desarrolladores como los usuarios en general, y en especial los docentes, seamos conscientes del potencial pero también de los límites y riesgos asociados al uso de esta tecnología tan poderosa e innovadora.

Si te ha parecido útil o interesante este contenido háznoslo saber en los comentarios o en nuestras redes sociales y no olvides suscribirte para no perderte nada.